Sprachdenkproben

Postulation als Erinnerungshilfe

Das Phänomen der inneren Rede kann als ein Medium der Repräsentation unserer Denkprozesse, von unseren Gedanken beschrieben werden. Denkprozesse können auf subpersonaler Ebene mit vollständig naturalistischem Vokabular (neuronale Netze) erklärt werden. Auf der Subjektebene erlebt sich ein kognitives System auf Basis von linguistischen Repräsentationen als denkend und Zugang zu Gedanken habend. Ein Teil der Phänomenologie des Denkens besteht demnach in einem Erfahren einer Darstellung (für uns) von Gedanken und Prozessen des Denkens in Sprache.

Die Frage, ob natürliche Sprache, verwandt in innerer Rede, das Denken beeinflusst, kann selbstverständlich bejaht werden.

Funktionen der inneren Rede reichen von ökonomischer Abstraktionsleistung über die eigenen Denkprozesse, die Sprachproduktion unterstützende Simulation, über Antizipation von Kommunikationsverläufen, Handlungsplanung und Verhaltensmanipulation anderer Menschen bis zur verbalen Unterstützung einer modellierten Darstellung des Selbst …

Ein kognitives System erhält vielfältigen Input aus einer komplexen Umwelt. Seine Aufgabe besteht u.a. darin, aus diesem möglichen Input brauchbare Information zu generieren, d.i. im Chaos der Stimuli Muster und Regeln zu erkennen und abstrahieren.

Eine Quelle brauchbaren Inputs liefert die natürliche Sprache.

Ein Teil des Denkens wird über den Spracherwerb strukturiert. Grammatik und Bedeutung liegen nicht angeboren in einer Sprache des Geistes (wie sollte unser Genom all diese Information speichern), sondern werden erlernt. Muster sprachlichen Inputs dienen als Material, aus dem Regeln und Bedeutungen extrahiert werden.

Wir werden geboren mit einem kleinen Set an kognitiven Fähigkeiten. Wir re-programmieren unseren Geist nicht, wir spielen auch keine Software auf einer statischen Hardware ab, sondern re-organisieren und augmentieren sie selbst.

Die Systematizität und Produktivität des Denkens ergibt sich aus einem Umgang mit der erlernten Sprache. Worte sind eine neue Objektklasse, input- und kontextfern verfügbare Abstraktionen von Katalogen von Eigenschaften. Ein Teil des abstrakten Denkens liegt in der Verwendung von diesen Abstraktionen.

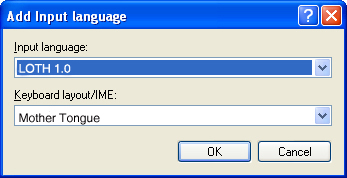

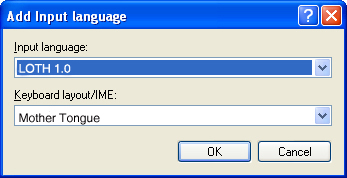

Es gibt eine LOTH, aber sie ist Ergebnis des Erlernens unserer Muttersprache. Die Konstituentenstruktur und Grammatikalität des Geistes, ist Resultat, nicht Voraussetzung von Spracherwerb. LOTH kommt zum Einsatz, wenn wir auf Basis dieser erlernten Regeln und Bedeutungen weiteren Input erschließen.

Innere Rede ist eine Repräsentation der anerlernten LOTH.

Das Phänomen der inneren Rede kann als ein Medium der Repräsentation unserer Denkprozesse, von unseren Gedanken beschrieben werden. Denkprozesse können auf subpersonaler Ebene mit vollständig naturalistischem Vokabular (neuronale Netze) erklärt werden. Auf der Subjektebene erlebt sich ein kognitives System auf Basis von linguistischen Repräsentationen als denkend und Zugang zu Gedanken habend. Ein Teil der Phänomenologie des Denkens besteht demnach in einem Erfahren einer Darstellung (für uns) von Gedanken und Prozessen des Denkens in Sprache.

Die Frage, ob natürliche Sprache, verwandt in innerer Rede, das Denken beeinflusst, kann selbstverständlich bejaht werden.

Funktionen der inneren Rede reichen von ökonomischer Abstraktionsleistung über die eigenen Denkprozesse, die Sprachproduktion unterstützende Simulation, über Antizipation von Kommunikationsverläufen, Handlungsplanung und Verhaltensmanipulation anderer Menschen bis zur verbalen Unterstützung einer modellierten Darstellung des Selbst …

Ein kognitives System erhält vielfältigen Input aus einer komplexen Umwelt. Seine Aufgabe besteht u.a. darin, aus diesem möglichen Input brauchbare Information zu generieren, d.i. im Chaos der Stimuli Muster und Regeln zu erkennen und abstrahieren.

Eine Quelle brauchbaren Inputs liefert die natürliche Sprache.

Ein Teil des Denkens wird über den Spracherwerb strukturiert. Grammatik und Bedeutung liegen nicht angeboren in einer Sprache des Geistes (wie sollte unser Genom all diese Information speichern), sondern werden erlernt. Muster sprachlichen Inputs dienen als Material, aus dem Regeln und Bedeutungen extrahiert werden.

Wir werden geboren mit einem kleinen Set an kognitiven Fähigkeiten. Wir re-programmieren unseren Geist nicht, wir spielen auch keine Software auf einer statischen Hardware ab, sondern re-organisieren und augmentieren sie selbst.

Die Systematizität und Produktivität des Denkens ergibt sich aus einem Umgang mit der erlernten Sprache. Worte sind eine neue Objektklasse, input- und kontextfern verfügbare Abstraktionen von Katalogen von Eigenschaften. Ein Teil des abstrakten Denkens liegt in der Verwendung von diesen Abstraktionen.

Es gibt eine LOTH, aber sie ist Ergebnis des Erlernens unserer Muttersprache. Die Konstituentenstruktur und Grammatikalität des Geistes, ist Resultat, nicht Voraussetzung von Spracherwerb. LOTH kommt zum Einsatz, wenn wir auf Basis dieser erlernten Regeln und Bedeutungen weiteren Input erschließen.

Innere Rede ist eine Repräsentation der anerlernten LOTH.

Fluchtfliege - 15. Feb, 13:35

Interessiert dich vielleicht

In „Bild der Wissenschaft“ 2/2006 ist ein Artikel mit dem Titel „Lies dich schlau“, der sich mit einem Vergleich unserer Sprachen mit dem Chinesischen beschäftigt. Chinesisch ist eine Silbensprache, es gibt keine Wortzwischenräume und keine Interpunktionszeichen. Es wird daher anders gelesen, man kann z.B. nicht mit den Augen beim Lesen zurückspringen. Außerdem gibt es keine Konjugation, keine Deklination, keinen Singular oder Plural, keine Vergangenheit und Zukunft. Man muss sich das alles aus dem Kontext erschließen und begreift manche Dinge erst später.

Es wird darüber spekuliert, ob das erstens Auswirkungen auf das „östliche“ Denken hat, in dem viele Dinge bis zuletzt in der Schwebe gehalten werden, und ob es zweitens die Wahrnehmung verändert. Zum Beispiel wird von einem Test berichtet, bei der die Versuchspersonen den Inhalt eines Aquariums beschreiben sollten. Den Deutschen fielen vor allem die Fische auf, die Chinesen konnten kleinste Details wiedergeben, inklusive Algen und Steinen. Ein ähnliches Experiment kenne ich auch mit einer Waldszene mit vergleichbarer Aussage.